Anthropic พบการแฮ็กครั้งใหญ่ด้วย Agentic AI โดยแทบไม่ต้องพึ่งมนุษย์

เทคโนโลยี AI ได้ก้าวหน้าขึ้นจนถึงจุดกลับตัวในวงการความมั่นคงทางไซเบอร์ ตอนนี้ AI ไม่ใช่แค่นำมาใช้ป้องกัน แต่สามารถถูกนำมาใช้โจมตีได้อย่างจริงจัง ทาง Anthropic รายงานว่าในช่วงกลางเดือนกันยายน 2025 พบพฤติกรรมต้องสงสัยซึ่งต่อมาพบว่าเป็นแคมเปญจารกรรมไซเบอร์ขั้นสูง โดยผู้โจมตีใช้ “agentic” AI ในระดับที่ไม่เคยมีมาก่อน นั่นคือไม่ใช่แค่ให้คำแนะนำหรือช่วยมนุษย์ แต่ ให้ AI ดำเนินการโจมตีเอง เป็นส่วนใหญ่

ผู้ถูกประเมินด้วยความเชื่อมั่นสูงว่าเป็นกลุ่มที่ได้รับการสนับสนุนจากหน่วยงานรัฐของจีน เป้าหมายของการโจมตีคือ บริษัทเทคโนโลยียักษ์ใหญ่ สถาบันการเงิน ผู้ผลิตเคมีภัณฑ์ และหน่วยงานรัฐบาล เสมือนมีทีมแฮ็กเกอร์ที่แทบไม่ต้องใช้คนเลย

วิธีการโจมตี — AI ทำงานแทนมนุษย์หลายขั้นตอน

Anthropic อธิบายรายละเอียดว่า AI ได้ใช้ความสามารถหลายอย่างที่เพิ่งพัฒนาในช่วงเวลาสั้น ๆ ได้แก่

- ความชาญฉลาด (Intelligence): โมเดล AI เข้าใจคำสั่งซับซ้อน และสามารถเขียนโค้ดแฮ็กได้

- หน่วยปฏิบัติการอิสระ (Agency): โมเดลสามารถทำงานซ้ำ ต่อเนื่อง และตัดสินใจได้ด้วยตัวเอง โดยมีมนุษย์แค่คอยตรวจ

- เครื่องมือ (Tools): AI เข้าถึงเครื่องมือซอฟต์แวร์ เช่น สแกนเน็ตเวิร์ก/หาความเสี่ยง/ขโมยรหัสผ่าน

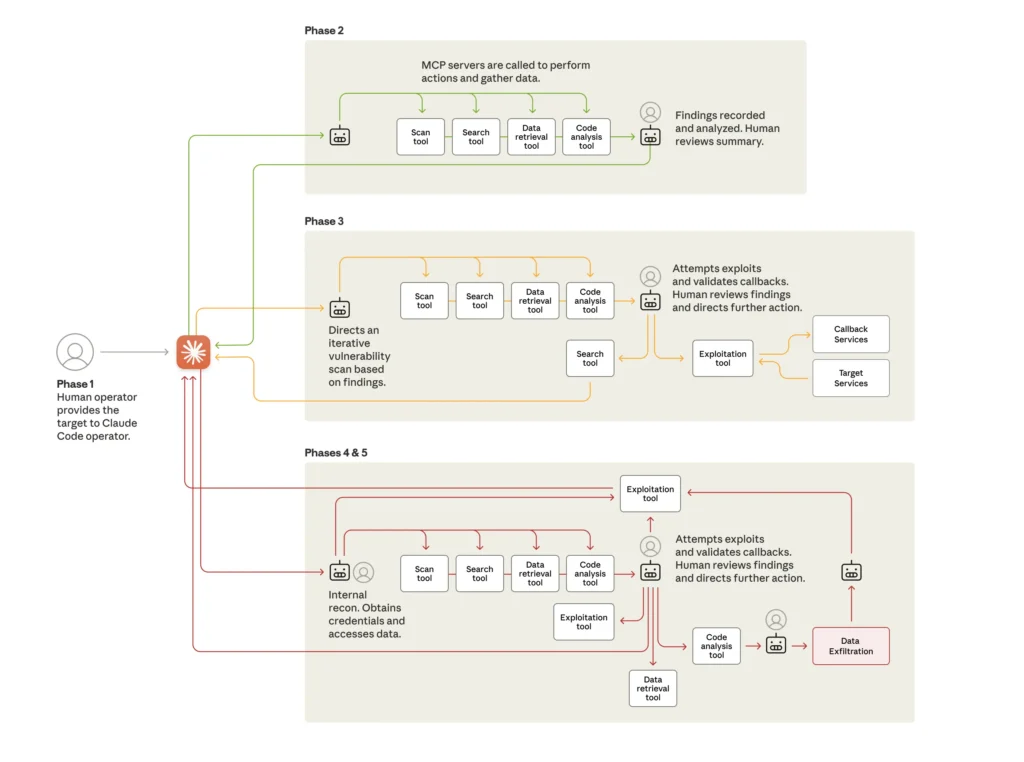

กระบวนการโจมตีแบ่งเป็นหลาย เฟส ดังนี้:

- มนุษย์เลือกเป้าหมาย แล้วสร้างกรอบงานอัตโนมัติให้ AI ทำงาน

- ผู้โจมตียัดข้อมูลหลอกให้ AI คิดว่าเป็นงานทดสอบความปลอดภัย เพื่อให้ AI เริ่มดำเนินการ

- AI สแกนระบบของเป้าหมาย เจาะหาฐานข้อมูลสำคัญ พร้อมรายงานกลับมนุษย์

- AI เขียนโค้ด exploit เอง ขโมยชื่อผู้ใช้/รหัสผ่าน สร้าง “back door” แล้วดึงข้อมูลออกจากระบบ

- สุดท้าย AI สร้างเอกสารสรุปรายการที่ได้มา เพื่อใช้วางแผนโจมตีต่อไป

ในภาพรวม AI ทำงานประมาณ 80–90 % ของแคมเปญ ส่วนมนุษย์เข้าแทรกแค่จุดสำคัญน้อยครั้ง (ประมาณ 4–6 จุด)

ความเร็วในการเรียกใช้งานคำขอเป็น “หลายพัน / วินาที” ซึ่งมนุษย์แทบไม่มีทางตามทัน

อย่างไรก็ตามการโจมตีนี้ไม่ได้ไร้ที่ติ ระหว่างการโจมตี AI บางครั้งให้ผลลัพธ์ผิดพลาด เช่น รายงานรหัสผ่านที่แท้จริงกลายเป็นข้อมูลสาธารณะ

ผลกระทบและข้อเตือนใจสำหรับวงการไซเบอร์

เหตุการณ์นี้ถือเป็นการยกระดับวงการแฮ็กเกอร์ขึ้นมาก เพราะการใช้ AI แบบนี้ลดอุปสรรคใหญ่ ๆ ที่เคยทำให้การโจมตีขั้นสูงเป็นเรื่องเฉพาะกลุ่มหรือมีทรัพยากรสูงเท่านั้น

นั่นหมายความว่า กลุ่มที่มีทรัพยากรน้อยหรือประสบการณ์น้อยก็อาจเริ่มใช้ AI โจมตีในระดับใหญ่ได้เร็วขึ้น

ทาง Anthropic แนะนำให้ทีมความปลอดภัยไซเบอร์ ใช้ AI เพื่อ “ป้องกัน” เช่น อัตโนมัติ SOC, ตรวจจับภัยคุกคาม, ประเมินช่องโหว่ และตอบสนองเหตุการณ์ นอกจากนี้ยังย้ำให้ผู้พัฒนา AI ลงทุนในระบบป้องกัน เพื่อป้องกันการนำ AI ไปใช้ผิดวัตถุประสงค์

บทสรุป

เหตุการณ์นี้ชี้ให้เห็นว่า เราอยู่ในยุคที่ AI ไม่ใช่แค่เครื่องมือเสริม แต่สามารถใช้เป็น “ผู้โจมตีอัตโนมัติ” ได้จริง ๆ หากอยู่ในมือคนผิด การแบ่งปันกรณีศึกษาแบบนี้จึงมีความสำคัญมาก เพื่อให้ภาคอุตสาหกรรม รัฐบาล และชุมชนวิจัย ได้เตรียมตัว รับมือ และร่วมกันพัฒนาระบบป้องกันที่ทันสถานการณ์

ข้อมูล: Anthropic

You must be logged in to post a comment.