Claude AI ปรับนโยบาย ขอใช้ข้อมูลการสนทนากับผู้ใช้เพื่อฝึกโมเดล AI

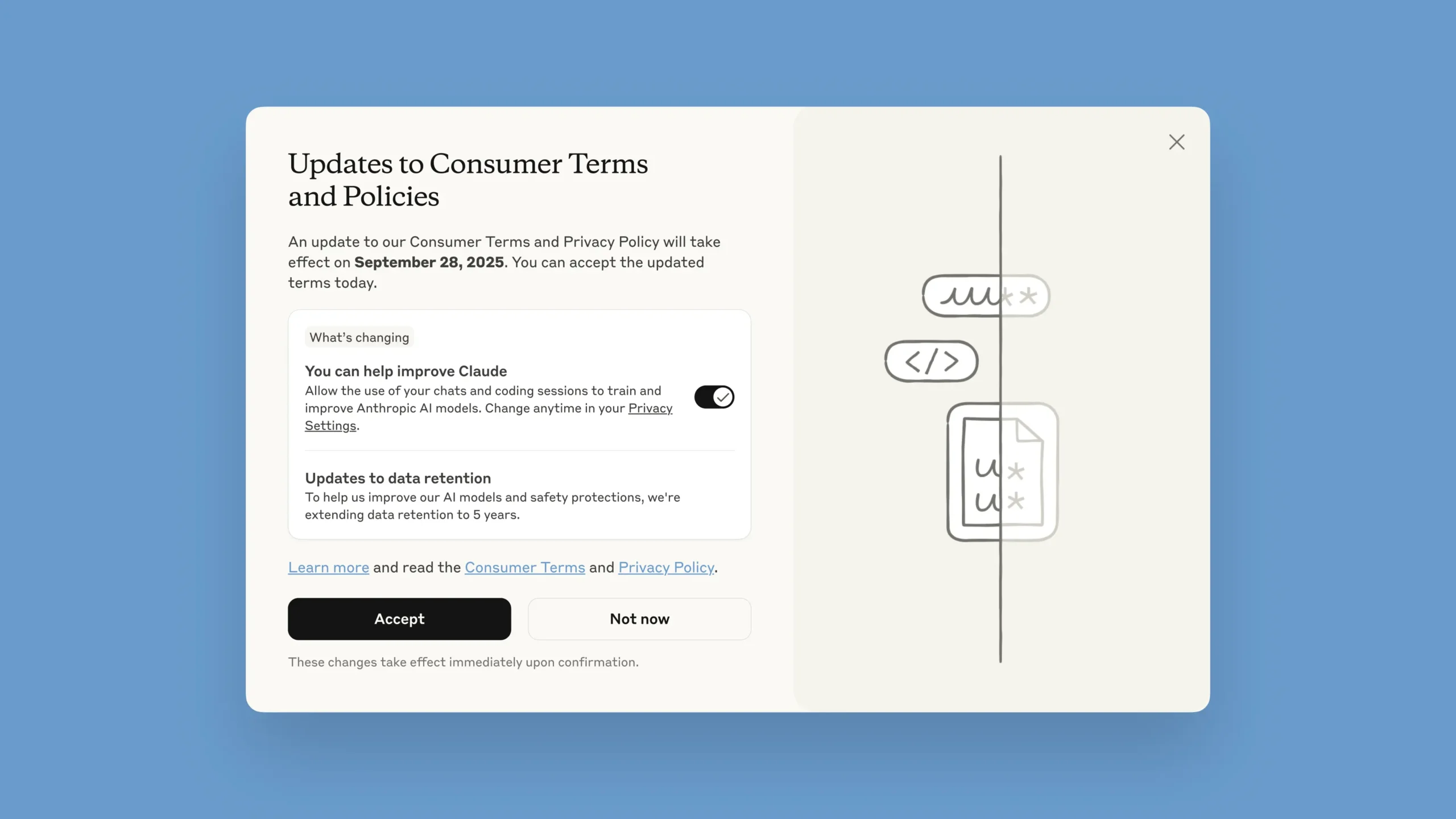

บริษัท Anthropic ผู้พัฒนาโมเดล AI อย่าง Claude ได้ประกาศอัปเดตข้อกำหนดสำหรับผู้ใช้และนโยบายความเป็นส่วนตัวครั้งสำคัญ โดยมีเป้าหมายเพื่อยกระดับความสามารถของโมเดล AI และเพิ่มความปลอดภัยในการใช้งาน โดยการเปลี่ยนแปลงนี้จะมีผลกับผู้ใช้ในแผน Claude Free, Pro และ Max รวมถึงผู้ใช้ Claude Code ที่เชื่อมโยงกับแผนเหล่านี้

ทำไมต้องขอข้อมูลจากผู้ใช้

โดยทั่วไปแล้ว การพัฒนา Large Language Model (LLM) เช่น Claude จำเป็นต้องใช้ข้อมูลปริมาณมหาศาลเพื่อฝึกฝน ซึ่งข้อมูลจากปฏิสัมพันธ์ของผู้ใช้จริงถือเป็น “อาหารชั้นเลิศ” ที่ทำให้ AI เรียนรู้และเข้าใจว่าการตอบสนองแบบไหนที่มีประโยชน์และแม่นยำที่สุด ยกตัวอย่างเช่น เมื่อนักพัฒนาใช้ Claude เพื่อช่วยแก้ไข Code การโต้ตอบนั้นจะเป็นข้อมูลเชิงลึกที่ช่วยให้โมเดลในอนาคตเก่งขึ้นในเรื่องการเขียนโปรแกรม ซึ่งเป็นกระบวนการที่สร้าง Feedback Loop ให้ AI มีพัฒนาการอย่างต่อเนื่อง

Anthropic จึงมองว่าการเปิดให้ผู้ใช้มีส่วนร่วมในกระบวนการนี้ จะช่วยให้:

- ปรับปรุงความปลอดภัยของโมเดล: ระบบตรวจจับเนื้อหาที่เป็นอันตราย (Harmful Content) จะมีความแม่นยำขึ้น ทำให้ลดโอกาสการแจ้งเตือนผิดพลาดในการสนทนาที่ไม่มีอันตราย

- พัฒนาความสามารถหลัก: โมเดล Claude ในอนาคตจะมีความสามารถด้านต่างๆ เช่น การเขียน Code, การวิเคราะห์ และการใช้เหตุผล ที่ดีขึ้น

- รักษาความสม่ำเสมอ: วงจรการพัฒนา AI ใช้เวลานานหลายปี การเก็บข้อมูลอย่างต่อเนื่องช่วยให้โมเดลที่ได้รับการอัปเกรดมีความสอดคล้องกันมากขึ้น ทำให้การเปลี่ยนผ่านราบรื่นสำหรับผู้ใช้

สรุปการเปลี่ยนแปลงสำคัญและสิ่งที่ผู้ใช้ต้องทราบ

- การเลือกให้ข้อมูล: ผู้ใช้ Claude Free, Pro และ Max (รวมถึงการใช้งาน Claude Code) จะมีตัวเลือกให้ยินยอมหรือไม่ยินยอมให้ใช้ข้อมูลเพื่อฝึกฝนโมเดล

- นโยบายนี้มีผลกับใคร: ครอบคลุมผู้ใช้ทั่วไปทั้งแบบฟรีและแบบเสียเงิน แต่ ไม่รวมถึง ผู้ใช้งานในกลุ่มเชิงพาณิชย์ภายใต้ Commercial Terms เช่น Claude for Work (Team และ Enterprise), Claude Gov, Claude for Education และการใช้งานผ่าน API หรือแพลตฟอร์มของบุคคลที่สามอย่าง Amazon Bedrock และ Google Cloud’s Vertex AI

- การเก็บรักษาข้อมูลนานขึ้น: หากผู้ใช้เลือกที่จะอนุญาตให้ใช้ข้อมูลเพื่อฝึกฝนโมเดล ระยะเวลาการเก็บข้อมูลจะขยายจาก 30 วันเป็น 5 ปี เพื่อสนับสนุนการพัฒนาและปรับปรุงความปลอดภัยในระยะยาว โดยนโยบายใหม่นี้จะเริ่มมีผลกับบทสนทนาและการเขียน Code ที่เริ่มใหม่หรือกลับมาทำต่อเท่านั้น ข้อมูลเก่าที่ไม่มีการเคลื่อนไหวจะไม่ถูกนำไปใช้ หากผู้ใช้เลือกที่จะไม่ให้ข้อมูล ระยะเวลาเก็บข้อมูลจะยังคงเป็น 30 วันตามเดิม

- การควบคุมสิทธิ์: ผู้ใช้สามารถเปลี่ยนการตั้งค่านี้ได้ตลอดเวลาใน Privacy Settings และสามารถลบข้อมูลการสนทนาเพื่อไม่ให้ถูกนำไปใช้ในการฝึกฝนโมเดลในอนาคตได้

- เส้นตายและขั้นตอน:

- ผู้ใช้ปัจจุบัน: จะได้รับการแจ้งเตือนในแอปพลิเคชันและมีเวลาตัดสินใจจนถึงวันที่ 28 กันยายน 2025 หากไม่เลือกการตั้งค่าใดๆ หลังจากวันดังกล่าว จะไม่สามารถใช้งาน Claude ต่อได้

- ผู้ใช้ใหม่: จะมีตัวเลือกให้ตั้งค่านี้ตั้งแต่ขั้นตอนการสมัครใช้งาน

การตัดสินใจของ Anthropic ในครั้งนี้แสดงให้เห็นถึงแนวทางที่บริษัทใหญ่ ๆ ด้าน AI กำลังเผชิญอยู่ระหว่างการพัฒนาโมเดลให้ฉลาดขึ้นด้วยข้อมูลจากผู้ใช้ กับการรักษานโยบายความเป็นส่วนตัว ซึ่งการเปิดโอกาสให้ผู้ใช้มีสิทธิ์ตัดสินใจด้วยตัวเองถือเป็นทางออกที่ช่วยสร้างความโปร่งใสและมอบอำนาจให้แก่ผู้ใช้งานในการควบคุมข้อมูลของตนเอง ซึ่งเป็นแนวทางที่น่าจับตามองในอุตสาหกรรมเทคโนโลยีในปัจจุบัน

ที่มา: Anthropic Blog Post