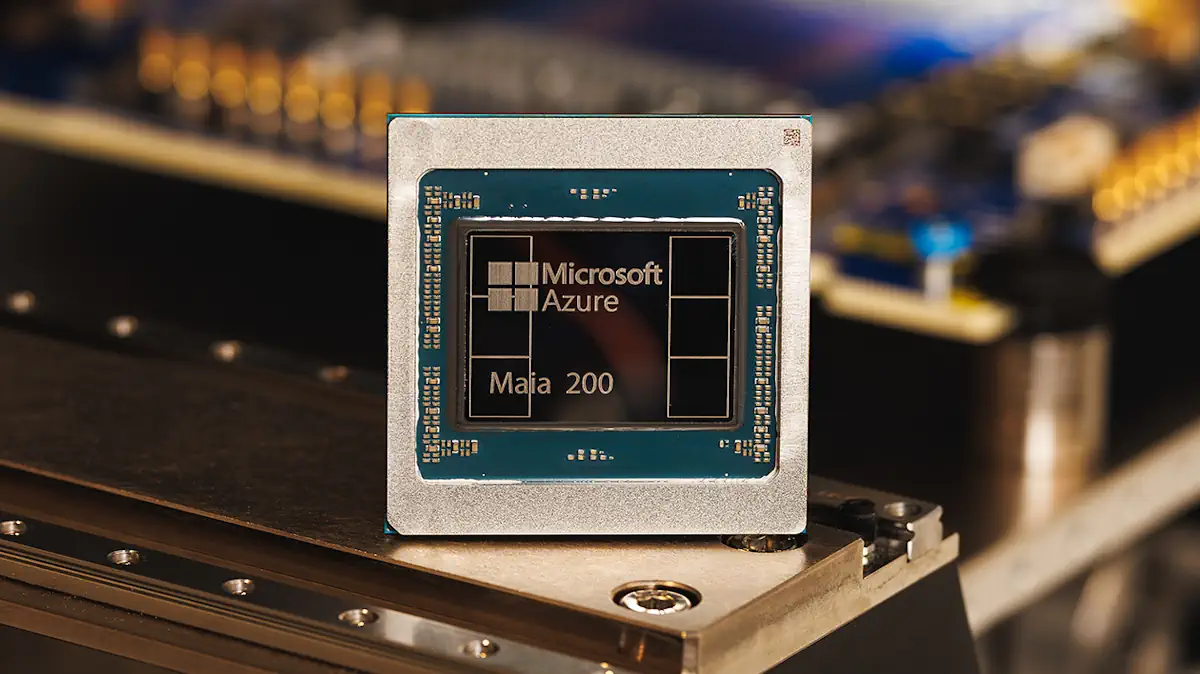

Microsoft เปิดตัวชิปประมวลผลเอไอ Maia 200 รุ่นที่สอง ท้าชน Nvidia และลดการพึ่งพาฮาร์ดแวร์จากภายนอก

เมื่อวันจันทร์ที่ผ่านมา (26 มกราคม 2569) Microsoft ได้ประกาศเปิดตัว Maia 200 ชิปประมวลผลเอไอรุ่นที่สองที่พัฒนาเองทั้งหมด ซึ่งถือเป็นก้าวสำคัญในการยกระดับการแข่งขันชิปเอไอ ระหว่างยักษ์ใหญ่เทคโนโลยี โดยมีเป้าหมายหลักคือลดการพึ่งพาชิปจาก Nvidia ซึ่งครองตลาดตัวชิปเร่งความเร็ว AI อยู่ราว 85% ในปัจจุบัน

ชิป Maia 200 เริ่มใช้งานจริงในศูนย์ข้อมูลที่รัฐไอโอวาแล้วในสัปดาห์นี้ และมีแผนจะขยายไปยังศูนย์ข้อมูลแห่งที่สองในรัฐแอริโซนาเร็ว ๆ นี้ ชิป Maia 200 ถูกออกแบบมาเพื่องานด้าน AI inference (การนำโมเดล AI ไปใช้งานจริง เช่น การตอบคำถามหรือสร้างเนื้อหา) โดย Microsoft อ้างว่าชิปให้ประสิทธิภาพ FP4 สูงกว่าชิป Trainium รุ่นที่สามของ Amazon และ TPU ของ Google ถึง 3 เท่าในบาง workload นอกจากนี้ยังมีหน่วยความจำ HBM3e ขนาด 216GB และ bandwidth สูง ทำให้ตอบสนองได้เร็วและเสถียร โดยเฉพาะในระบบแชทบอทหรือแอปพลิเคชันที่รับคำขอจากผู้ใช้จำนวนมาก

ท้าทายจุดแข็งด้านซอฟต์แวร์ของ Nvidia

สิ่งที่น่าสนใจยิ่งกว่าคือ Microsoft ไม่ได้แข่งแค่ด้านฮาร์ดแวร์เท่านั้น แต่ยังเล็งเป้าไปที่ CUDA แพลตฟอร์มซอฟต์แวร์ที่เป็นเหมือนกำแพงป้องกันสำคัญของ Nvidia ซึ่งทำให้เหล่านักพัฒนาติดอยู่ใน ecosystem ของ Nvidia อย่างยากจะเปลี่ยน

Microsoft จึงประกาศนำ Triton เครื่องมือเขียนโปรแกรมแบบ open-source ที่พัฒนาร่วมกับ OpenAI มาใช้กับ Maia 200 โดย Triton ช่วยให้นักวิจัยที่ไม่มีประสบการณ์ CUDA สามารถเขียนโค้ดสำหรับ GPU ได้ใกล้เคียงกับระดับผู้เชี่ยวชาญ (ตามที่ OpenAI เคยเปิดตัวครั้งแรกในปี 2021) การเคลื่อนไหวนี้มีเป้าหมายชัดเจนคือลดต้นทุนการเปลี่ยนผ่านให้เหล่านักพัฒนาสามารถย้ายมาใช้ชิปของ Microsoft ได้ง่ายขึ้น

การผลิตและเทคโนโลยี

Maia 200 ผลิตโดย TSMC ด้วยเทคโนโลยี 3 นาโนเมตร และใช้หน่วยความจำ HBM (high-bandwidth memory) แม้จะเป็นรุ่นเก่ากว่ารุ่นที่จะมาในชิป “Vera Rubin” ของ Nvidia ที่เพิ่งประกาศเมื่อต้นเดือนนี้ แต่ชิปตัวนี้มีทรานซิสเตอร์มากถึง 144 พันล้านตัว และให้พลังประมวลผลสูงสุด 10 petaFLOPS ใน FP4 พร้อมใช้พลังงานเพียง 750 วัตต์ ซึ่ง Microsoft เคลมว่าถูกกว่าและประหยัดพลังงานกว่าคู่แข่งอื่น ๆ ราว 30%

แนวโน้มอุตสาหกรรม: Cloud ยักษ์ใหญ่สร้างชิปเอง

การเปิดตัว Maia 200 สะท้อนเทรนด์ใหญ่ในวงการที่ผู้ให้บริการคลาวด์รายใหญ่พยายามพัฒนาชิปเองเพื่อแข่งกับ Nvidia ทั้ง TPU ของ Google, Trainium สำหรับงานฝึกโมเดล และ Inferentia สำหรับรันโมเดลของ Amazon ต่างก็มีลูกค้าหลัก ๆ เริ่มหันมาใช้ชิปของผู้ให้บริการ Cloud มากขึ้นด้วยราคาที่ประหยัดกว่าละตอบโจทย์งานด้าน Inference โดยตรง

Microsoft ยังนำเทคนิคจากคู่แข่งหน้าใหม่มาใช้ เช่น การใส่ SRAM จำนวนมากเพื่อเพิ่มความเร็วในการตอบสนอง ซึ่งคล้ายกับแนวทางของ Cerebras Systems (ที่เพิ่งเซ็นดีลใหญ่กับ OpenAI) และ Groq (ที่เคยให้สิทธิ์เทคโนโลยีกับ Nvidia)

Maia 200 เป็นรุ่นต่อจาก Maia 100 ที่เปิดตัวปลายปี 2023 แต่การพัฒนาเจอความล่าช้าเนื่องจากการเปลี่ยนดีไซน์ตามคำขอจาก OpenAI และปัญหาการโยกย้ายบุคลากร ทำให้การผลิตจำนวนมากเลื่อนมาถึงปี 2026

ด้วยการรวมฮาร์ดแวร์และซอฟต์แวร์เข้าด้วยกันอย่างแนบแน่น Microsoft มุ่งหวังให้ Maia 200 เป็นตัวเลือกที่คุ้มค่าและมีประสิทธิภาพสูงสำหรับงาน AI ใน Azure, Microsoft 365 Copilot และโมเดลต่าง ๆ ของ OpenAI ในอนาคต ซึ่งอาจเปลี่ยนเกมการแข่งขันในตลาดชิปเร่งการประมวลผล AI ครั้งใหญ่