เผยความลับของ DeepSeek ในการใช้ NVIDIA GPU ฝึกโมเดลได้เร็วกว่าใคร

การเปิดตัวของ DeepSeek ทำให้เกิดคำถามสำคัญว่า การพัฒนาโมเดลภาษาขนาดใหญ่ (LLM – Large Language Model) ยังจำเป็นต้องพึ่งพาคลัสเตอร์ GPU ขนาดใหญ่อีกหรือไม่ หรือว่าการลงทุนมหาศาลของบริษัทเทคโนโลยียักษ์ใหญ่อย่าง Google, OpenAI, Meta และ xAI กลายเป็นเรื่องสูญเปล่า ไม่ว่าความจริงจะเป็นอย่างไร แต่ตอนนี้การมาของ DeepSeek ก็ทำให้ตลาดหุ้นเทคโนโลยีที่เขียวต่อเนื่องมาเป็นเวลานานถึงกับแดงยกกระดาน แม้แต่หุ้นของ NVIDIA ที่ได้เชื่อว่าเป็นการผูกขาดตลาดประมวลผล AI ก็ยังร่วงไปเป็นจำนวนมหาศาล โดยสูญเสียมูลค่าตลาดไปถึง 589 พันล้านดอลลาร์ เป็นการขาดทุนในวันเดียวที่ใหญ่ที่สุดในประวัติศาสตร์ตลาดหุ้นในวันที่ 27 มีนาคม ที่ผ่านมา

ความลับของ DeekSeek

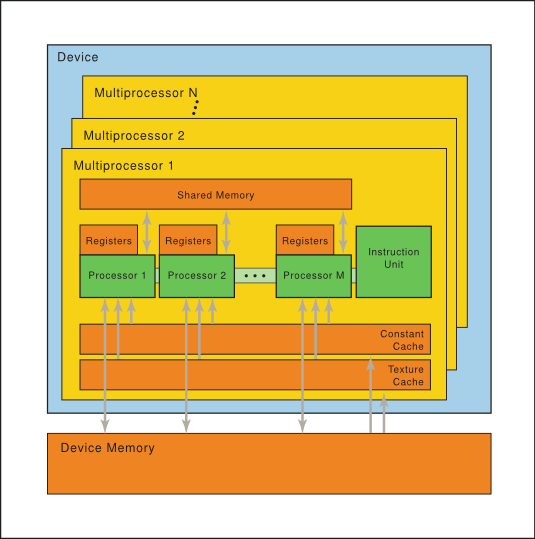

ความสำเร็จของ DeepSeek ในการใช้ GPU ของ NVIDIA มาจากการใช้ประโยชน์จาก PTX (Parallel Thread Execution) ซึ่งเป็นชุดคำสั่งระดับต่ำ (low-level parallel thread execution) ของ NVIDIA GPUs แทนที่จะใช้ CUDA ซึ่งเป็นภาษาโปรแกรมระดับสูง การทำเช่นนี้ช่วยให้ DeepSeek สามารถทำการปรับแต่งในระดับที่ละเอียดมาก เช่น การจัดสรรรีจิสเตอร์และการปรับแต่งระดับเธรด/วาร์ป ซึ่งไม่สามารถทำได้ใน CUDA

- การปรับแต่ง Streaming Multiprocessors (SMs): DeepSeek ได้ปรับแต่งส่วนประกอบหลักของ GPU ที่เรียกว่า SMs เพื่อให้เหมาะสมกับความต้องการของตนเอง โดยจาก 132 SMs, พวกเขาจัดสรร 20 SMs สำหรับงานสื่อสารระหว่างเซิร์ฟเวอร์ แทนที่จะใช้สำหรับการคำนวณ

- การปรับแต่งด้วย PTX: การปรับแต่งเหล่านี้ทำโดยใช้ชุดคำสั่งแบบ PTX ซึ่งเป็นระดับที่ใกล้เคียงกับภาษาแอสเซมบลี หรือเปรียบได้กับการเป็นภาษาแอสเซมบลีของ GPU ทำให้สามารถควบคุม GPU ได้อย่างละเอียด การควบคุมในระดับนี้มีความซับซ้อนและยากต่อการบำรุงรักษา

- ประสิทธิภาพที่สูงขึ้น: ด้วยการใช้ PTX และการปรับแต่งที่ละเอียด DeepSeek สามารถฝึกโมเดลภาษาขนาดใหญ่ (671 พันล้านพารามิเตอร์) ด้วยประสิทธิภาพที่สูงกว่าผู้นำในอุตสาหกรรมอย่าง Meta ถึง 10 เท่า โดยใช้เวลาประมาณสองเดือนบนคลัสเตอร์ที่มี 2,048 GPUs NVIDIA H800

- การแก้ปัญหาการขาดแคลน GPU: การขาดแคลน GPU ทั่วโลกและการคว่ำบาตรของสหรัฐฯ ต่อจีน ทำให้ DeepSeek ต้องหาทางแก้ไขปัญหาด้วยวิธีที่สร้างสรรค์ การใช้ PTX และการปรับแต่ง GPU ในระดับต่ำเป็นหนึ่งในวิธีที่ DeepSeek ใช้

- การใช้ Pipeline ขั้นสูง: DeepSeek ยังได้ใช้ pipeline algorithms ขั้นสูง โดยอาจจะปรับแต่งเธรดและวาร์ปในระดับที่ละเอียดมากเพื่อเพิ่มประสิทธิภาพ

อัปเดตเพิ่มเติม:

หนึ่งในบุคคลที่เห็นความสำคัญของ DeepSeek ตั้งแต่แรกคือ Andrej Karpathy ผู้ร่วมก่อตั้ง OpenAI และอดีตหัวหน้าทีม AI ของ Tesla เมื่อเดือนธันวาคมที่ผ่านมา เขาได้ทวีตเกี่ยวกับ DeepSeek V3 ซึ่งในขณะนั้นยังไม่ได้รับความสนใจมากนัก แต่เขาคาดการณ์ว่ามันจะมีความสำคัญอย่างมาก โมเดลนี้ถูกฝึกด้วยงบประมาณเพียง 6 ล้านดอลลาร์ โดยใช้ GPU เพียง 2,048 ตัวภายในสองเดือน ในขณะที่โมเดลระดับเดียวกันมักต้องใช้ GPU หลายหมื่นตัว ตัวอย่างเช่น LLaMA 3 ขนาด 405B ใช้พลังประมวลผล 30 ล้าน GPU ชั่วโมง แต่ DeepSeek V3 ใช้เพียง 2.8 ล้าน GPU ชั่วโมง ซึ่งแสดงให้เห็นถึงประสิทธิภาพที่เหนือกว่า

ประเด็นสำคัญที่ Karpathy เน้นย้ำคือ แม้การพัฒนาโมเดลระดับแนวหน้าจะยังต้องใช้พลังประมวลผลจำนวนมาก แต่สิ่งสำคัญคือการใช้ทรัพยากรอย่างมีประสิทธิภาพ DeepSeek แสดงให้เห็นว่ายังมีหนทางอีกมากในการพัฒนา AI ให้มีประสิทธิภาพสูงขึ้นโดยไม่ต้องใช้ทรัพยากรเกินความจำเป็น นอกจากนี้ สิ่งที่ทำให้ DeepSeek R1 น่าสนใจยิ่งขึ้นคือ มันไม่ได้ใช้การป้อนข้อมูลย้อนกลับจากมนุษย์ ซึ่งมักเป็นคอขวดของระบบ AI หลายตัว แต่ใช้เทคนิค deep learning และ self-play คล้ายกับที่ AlphaGo เคยใช้เพื่อเรียนรู้การเล่นโกะโดยไม่ต้องมีตัวอย่างจากมนุษย์

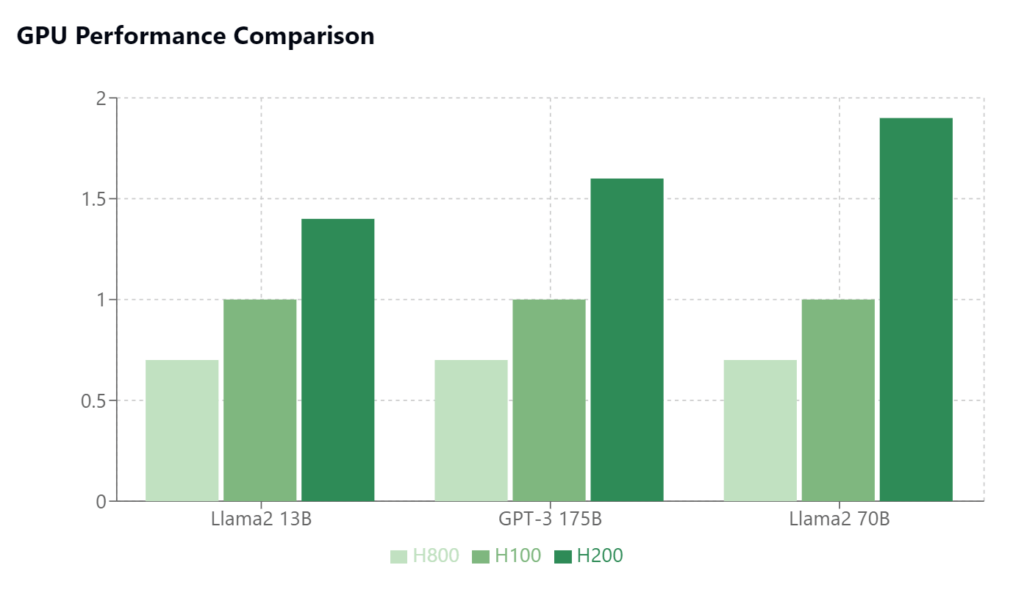

| คุณสมบัติ | NVIDIA H800 PCIe 80GB | NVIDIA H100 PCIe 80GB | NVIDIA H200 PCIe 141GB |

|---|---|---|---|

| สถาปัตยกรรม | Hopper | Hopper | Hopper |

| วันเปิดตัว | มีนาคม 2566 | มีนาคม 2565 | ไตรมาส 2 ปี 2566 |

| จำนวนทรานซิสเตอร์ | 80,000 ล้าน | 80,000 ล้าน | ข้อมูลไม่ระบุ |

| Base GPU Clock | 1,095 MHz | 1,095 MHz | 1,200 MHz |

| GPU Boost Clock | 1,755 MHz | 1,755 MHz | 1,980 MHz |

| ขนาดหน่วยความจำ | 80 GB HBM2e | 80 GB HBM2e | 141 GB HBM3e |

| แบนด์วิดธ์หน่วยความจำ | 2,039 GB/s | 2,040 GB/s | 4,800 GB/s |

| CUDA Cores (หน่วยประมวลผล) | 14,592 | 14,592 | ข้อมูลไม่ระบุ |

| Tensor Cores | 456 | 456 | ข้อมูลไม่ระบุ |

| TDP (การใช้พลังงาน) | 350 W | 350 W | ข้อมูลไม่ระบุ |

| ประสิทธิภาพ FP32 | 51.22 TFLOPS | 66.91 TFLOPS | ประมาณ 130 TFLOPS |

ด้านบนเป็นตารางเปรียบเทียบคุณสมบัติทางด้านฮาร์ดแวร์ของ NVIDIA H800 ที่เป็นการถูกลดประสิทธิภาพจาก H100 เพื่อส่งไปจีนโดยเฉพาะ และเมื่อเทียบกับ H200 ที่ออกมาในช่วงเวลาเดียวกันกับ H800 จะเห็นได้ว่า ประสิทธิภาพก็ยิ่งน้อยลงไปอีกเมื่อเทียบกับช่วงเวลาเดียวกัน

DeepSeek กับการกระตุ้นอุตสาหกรรม AI

แม้ว่า DeepSeek จะประสบความสำเร็จในการใช้ PTX เพื่อปรับแต่ง GPU และเพิ่มประสิทธิภาพในการฝึกโมเดลภาษาขนาดใหญ่ ซึ่งอาจทำให้เกิดความเชื่อว่าการพัฒนา LLM ไม่จำเป็นต้องใช้คลัสเตอร์ GPU ขนาดใหญ่อีกต่อไป ในการทำงานจริงเรายังคงต้องการสิ่งต่อไปนี้:

- ยังคงต้องใช้คลัสเตอร์ GPU ขนาดใหญ่: การปรากฏตัวของ DeepSeek ไม่ได้หมายความว่าการพัฒนา LLM ที่ล้ำสมัยจะไม่ต้องใช้คลัสเตอร์ GPU ขนาดใหญ่อีกต่อไป แม้ว่า DeepSeek จะสามารถปรับแต่ง GPU ได้อย่างละเอียด แต่การฝึกโมเดลภาษาขนาดใหญ่ยังคงต้องใช้ทรัพยากรประมวลผลจำนวนมาก

- การปรับแต่งเป็นเพียงส่วนหนึ่ง: แม้ DeepSeek จะใช้ PTX ในการปรับแต่ง GPU ในแบบ Low Level แต่ก็ไม่ได้หมายความว่าการลงทุนด้านคอมพิวเตอร์ขนาดใหญ่ของบริษัทอื่นๆ เช่น Google, OpenAI, Meta และ xAI จะไร้ประโยชน์ การปรับแต่ง GPU เป็นเพียงส่วนหนึ่งของการพัฒนา AI เท่านั้น ยังมีอีกหลายปัจจัยที่สำคัญ เช่น ข้อมูลและอัลกอริทึม

- ยังมีโอกาสในการปรับปรุง: ความสำเร็จของ DeepSeek ชี้ให้เห็นว่ายังมีโอกาสอีกมากในการปรับปรุงประสิทธิภาพของ AI ผ่านการปรับแต่งและการพัฒนาอัลกอริทึมใหม่ๆ และยังคาดว่าจะมีการพัฒนาวิธีการเพิ่มประสิทธิภาพใหม่ๆ ตามมาอีกมากมาย

- การขาดแคลน GPU เป็นแรงผลักดัน: การขาดแคลน GPU ทั่วโลกและการคว่ำบาตรของสหรัฐฯ ต่อจีนเป็นแรงผลักดันให้บริษัทต่างๆ เช่น DeepSeek ต้องหาวิธีการใหม่ๆ ในการใช้ทรัพยากรอย่างมีประสิทธิภาพ ซึ่งทำให้เกิดการปรับแต่ง GPU ในระดับล่างมากขึ้น

- PTX เป็นทางเลือกสำหรับการปรับแต่งแบบ low level: การใช้ PTX ซึ่งเป็นชุดคำสั่งระดับต่ำของ NVIDIA GPUs ช่วยให้ DeepSeek สามารถปรับแต่ง GPU ได้อย่างละเอียด เช่น การจัดสรรรีจิสเตอร์และการปรับแต่งระดับเธรด/วาร์ป ซึ่งไม่สามารถทำได้ใน CUDA

- ความซับซ้อนของการใช้ PTX: การใช้ PTX มีความซับซ้อนและยากต่อการบำรุงรักษา ซึ่งเป็นเหตุผลที่โดยทั่วไปแล้วนักพัฒนาจะใช้ภาษาโปรแกรมระดับสูงอย่าง CUDA แต่ DeepSeek ได้แสดงให้เห็นว่าการใช้ PTX สามารถให้ผลลัพธ์ที่น่าประทับใจได้เมื่อจำเป็นต้องใช้ทรัพยากร GPU ให้เต็มที่

DeepSeek ถูกเลือกใช้เพราะเป็น Open Source และ ต้นทุนที่ถูกกว่า

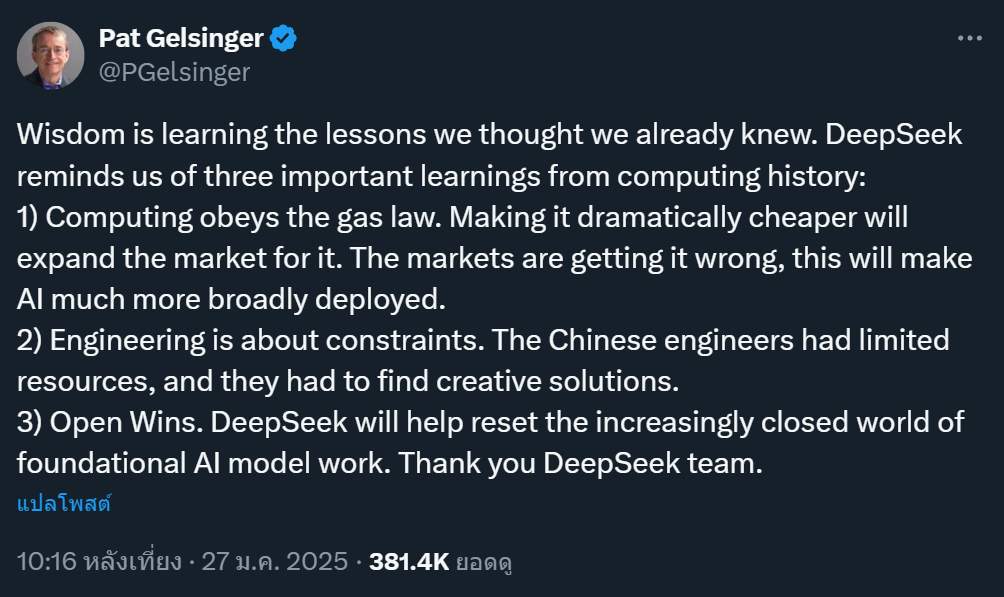

Pat Gelsinger อดีต CEO ของ Intel และปัจจุบันเป็นประธานของสตาร์ทอัพ Gloo ได้เลือกใช้ DeepSeek แทน OpenAI, Gloo กำลังสร้างบริการ AI ชื่อ Kallm โดยใช้โมเดล R1 ของ DeepSeek

นอกจากนี้ Gelsinger ยังได้โพสต์ข้อความไว้บน X ว่า

ภูมิปัญญาคือการเรียนรู้ บทเรียนที่เราคิดว่าเรารู้แล้ว DeepSeek เตือนเราถึงบทเรียนสำคัญสามประการจากประวัติศาสตร์การประมวลผล:

1) Gelsinger เปรียบเทียบการประมวลผลกับกฎของแก๊ส (Gas Law) ซึ่งหมายความว่า ยิ่งราคาถูกลงเท่าไหร่ ตลาดก็จะขยายตัวมากขึ้นเท่านั้น เขาเชื่อว่าตลาดประเมินศักยภาพของ AI ต่ำไป และการที่ DeepSeek ทำให้ AI ถูกลง จะช่วยให้ AI ถูกนำไปใช้อย่างแพร่หลายมากขึ้น

2) วิศวกรรมคือเรื่องของข้อจำกัด: Gelsinger ชื่นชม DeepSeek ที่สร้างสรรค์โซลูชันภายใต้ข้อจำกัดด้านทรัพยากร ซึ่งสะท้อนถึงความสามารถของวิศวกรชาวจีนในการแก้ปัญหาอย่างสร้างสรรค์

3) ชัยชนะของ Open Source: Gelsinger เชื่อว่า DeepSeek จะช่วยเปลี่ยนแปลงวงการ AI ที่กำลังอยู่ในระบบปิดมากขึ้น โดยส่งเสริมแนวคิด Open Source ซึ่งจะทำให้การพัฒนา AI เป็นไปอย่างเปิดกว้างและเข้าถึงได้มากขึ้น

ซึ่งทั้งหมดนี้แสดงให้เห็นถึงความเชื่อมั่นของ Gelsinger ใน DeepSeek ว่าจะสามารถเข้ามาเปลี่ยนแปลงและพัฒนาวงการ AI ไปในทิศทางที่ดีขึ้น

สรุป

อย่างไรก็ตามมีหลายความเห็นเช่นกันที่พูดถึง DeepSeek เรื่องการใช้ต้นทุนที่ต่ำว่า พวกเขาไม่ได้เริ่มจากศูนย์ แต่ต่อยอดจากงานของคนอื่นที่ทำไว้ก่อนแล้ว ซึ่งมันก็ใช่ แต่ถ้าจะมองแบบนั้นก็คงไม่ได้อะไร เพราะประเด็นสำคัญตอนนี้มันอยู่ที่แนวทางและแนวคิดของ DeekSeek ที่ทำให้เราต้องกลับมาคิดถึงรูปแบบการประยุกต์การใช้งานกับพื้นฐานที่เรามี ข้อจำกัดที่เรามีและเราจะทำให้ดีที่สุดบนข้อจำกัดนั้นได้อย่างไร โดยไม่ต้องไปยึดติดกับแนวคิดการทำงานแบบเดิม ๆ เพียงอย่างเดียว

โดยสรุปแล้ว การปรากฏตัวของ DeepSeek ไม่ได้หมายความว่าการพัฒนา LLM ไม่จำเป็นต้องใช้คลัสเตอร์ GPU ขนาดใหญ่อีกต่อไป แต่แสดงให้เห็นว่ายังมีโอกาสในการปรับปรุงประสิทธิภาพผ่านการปรับแต่ง GPU ในแบบ low level ด้วยการใช้ PTX, การพัฒนาอัลกอริทึมใหม่ ๆ และการใช้ทรัพยากรอย่างมีประสิทธิภาพ

ข้อมูลอ้างอิง: https://x.com/Jukanlosreve/status/1883304958432624881

You must be logged in to post a comment.